ScrapeStorm을 이용하여 네이버 사회 지역 뉴스를 스크래핑하는 방법 | 웹 스크래핑 툴 | ScrapeStorm

개요:이 글에서는 ScrapeStorm을 이용하여 네이버 사회 지역 뉴스를 스크래핑하는 방법을 소개합니다. ScrapeStorm무료 다운로드

뉴스 관련 정보를 수집하는 것은 일반적으로 번거롭고 뉴스 정보를 수집하고 정리하는 데 많은 시간이 걸립니다. 오늘은 ScrapeStorm을 이용해서 네이버 사회 지역 뉴스에 대한 정보를 대량으로 빠르게 수집하는 방법을 알려드리는데, 구체적으로 어떻게 진행되는지 알아보도록 하겠습니다~

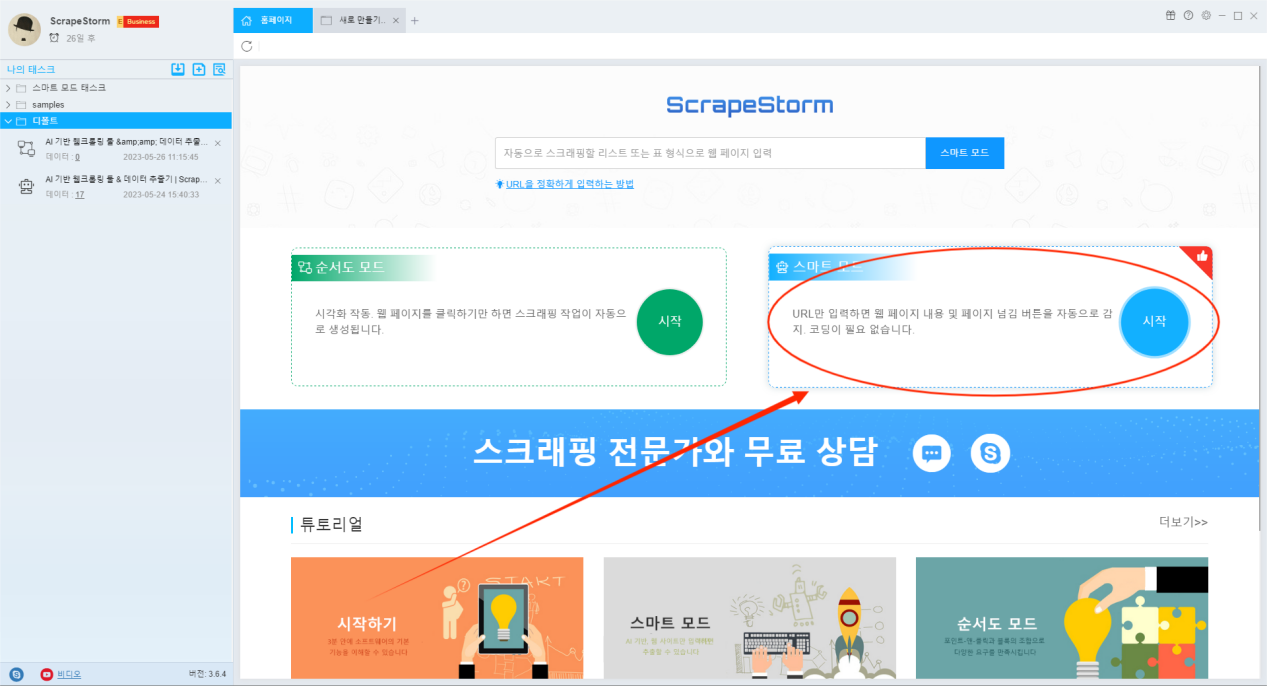

1. 태스크 만들기

ScrapeStorm을 사용하여 스크래핑을 수행하고 ‘스마트 모드’ 또는 ‘순서도 모드’ 를 선택하여 스크래핑 태스크를 생성할 수 있습니다. 우리는 ‘스마트 모드’ (’스마트 모드’ 는 ScrapeStorm팀이 인공지능 기술을 기반으로 개발한 신세대 스크래핑 모드입니다. )를 선택하여 태스크을 만듭니다. 소프트웨어 홈페이지에서 스마트 모드 ‘시작’ 을 선택합니다.

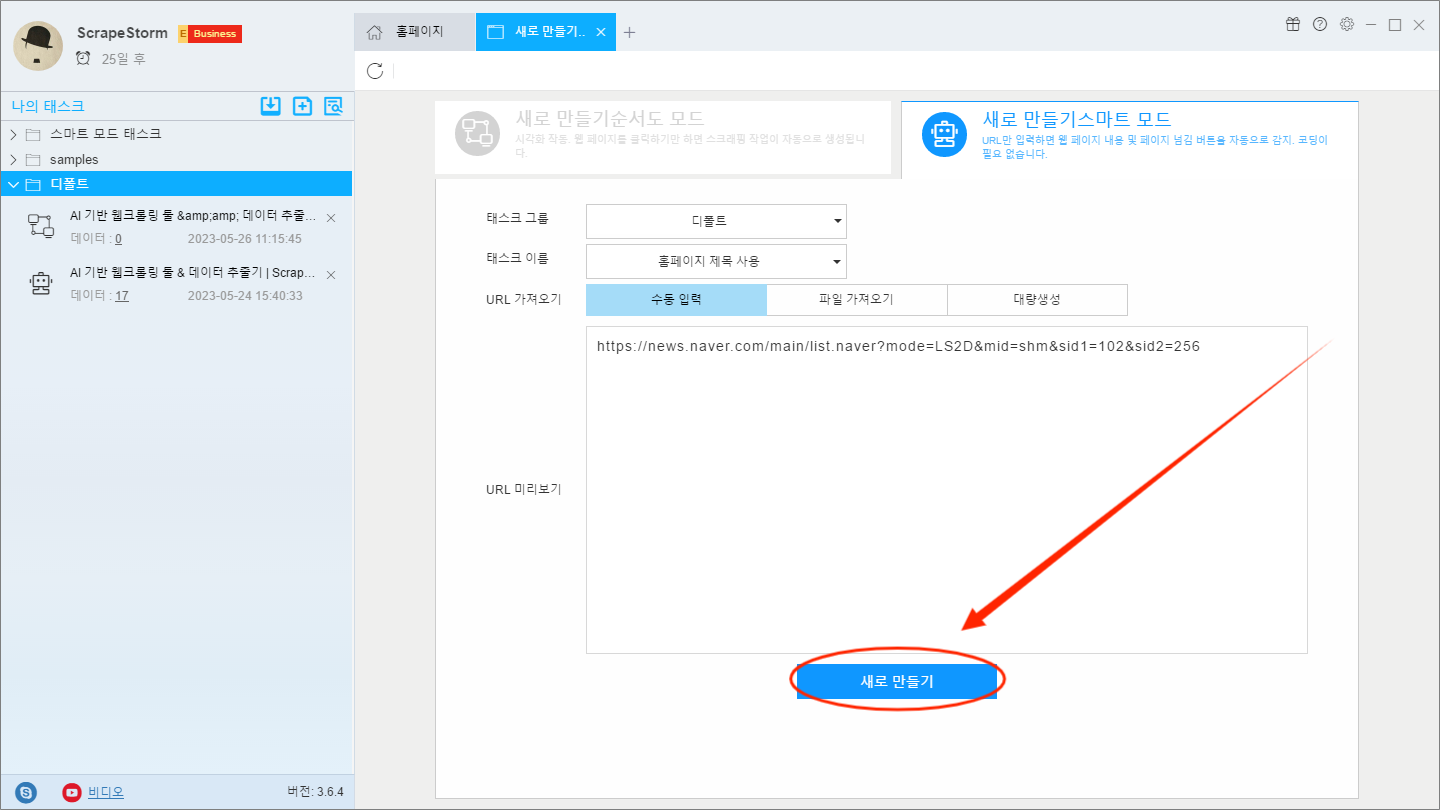

네이버 사회 지역 뉴스 웹 사이트 주소를 텍스트 상자에 복사하고 ‘새로 만들기’ 버튼을 클릭하여 새 태스크을 만듭니다.

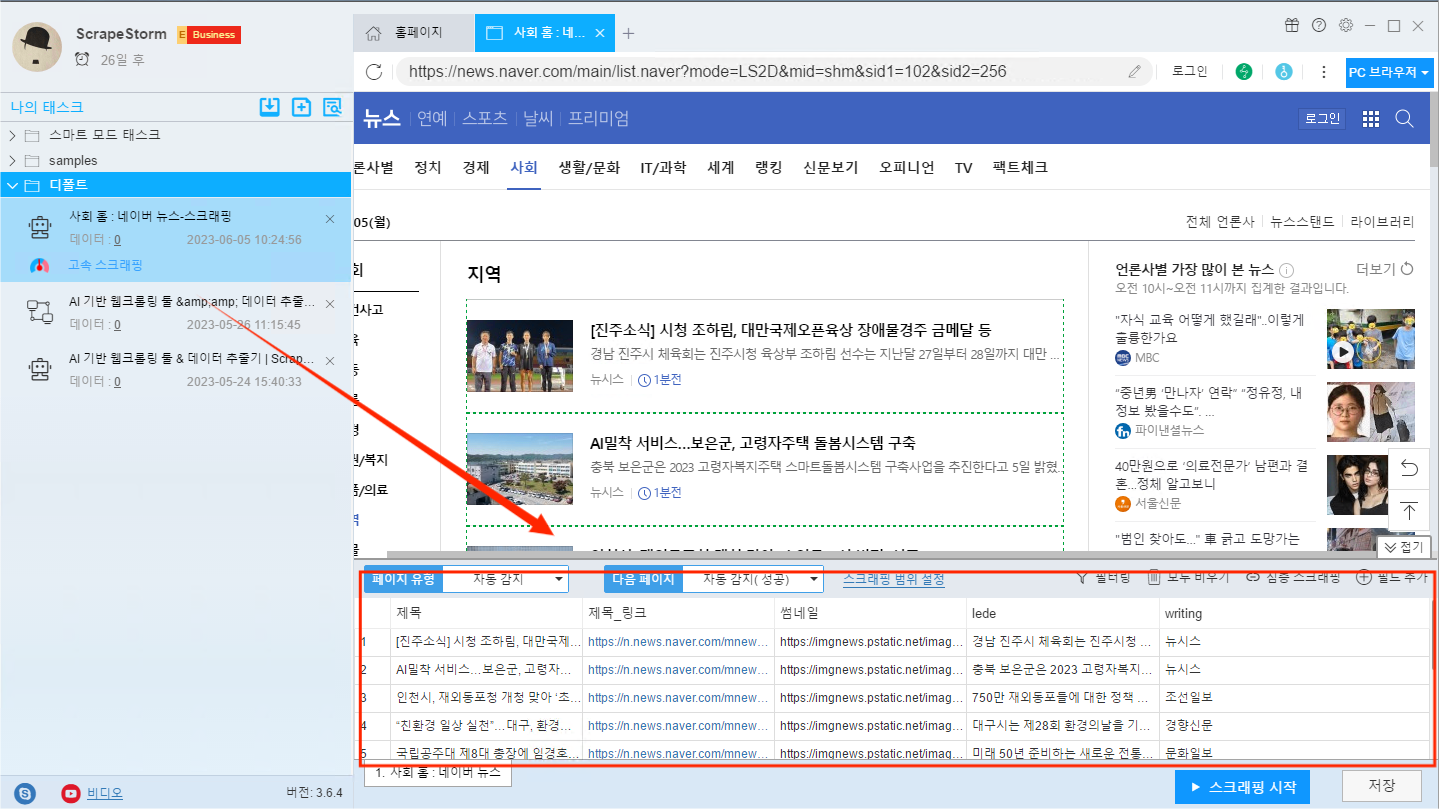

2. 태스크 설정하기

태스크를 만든 후 소프트웨어는 현재 리스트 페이지의 데이터를 자동으로 식별하고 필요에 따라 필드를 조정할 수 있습니다. 여기 소프트웨어는 이미 페이지에 있는 제목, 링크, 썸네일 링크등의 데이터를 자동으로 인식했습니다.

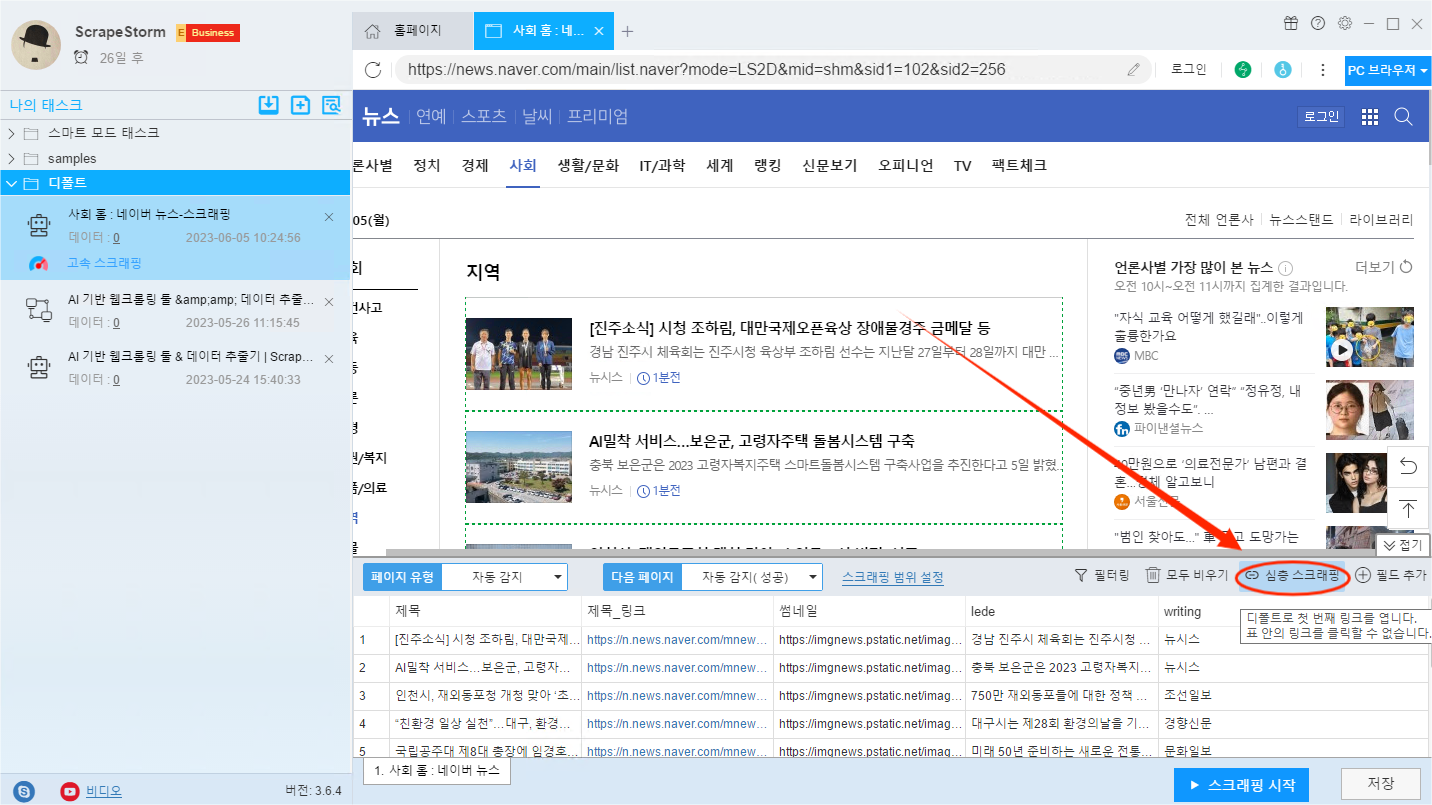

여기서 우리가 기사의 본문 내용을 수집하려면 심층 스크래핑을 해야 합니다. ‘심층 스크래핑’ 버튼을 클릭합니다.

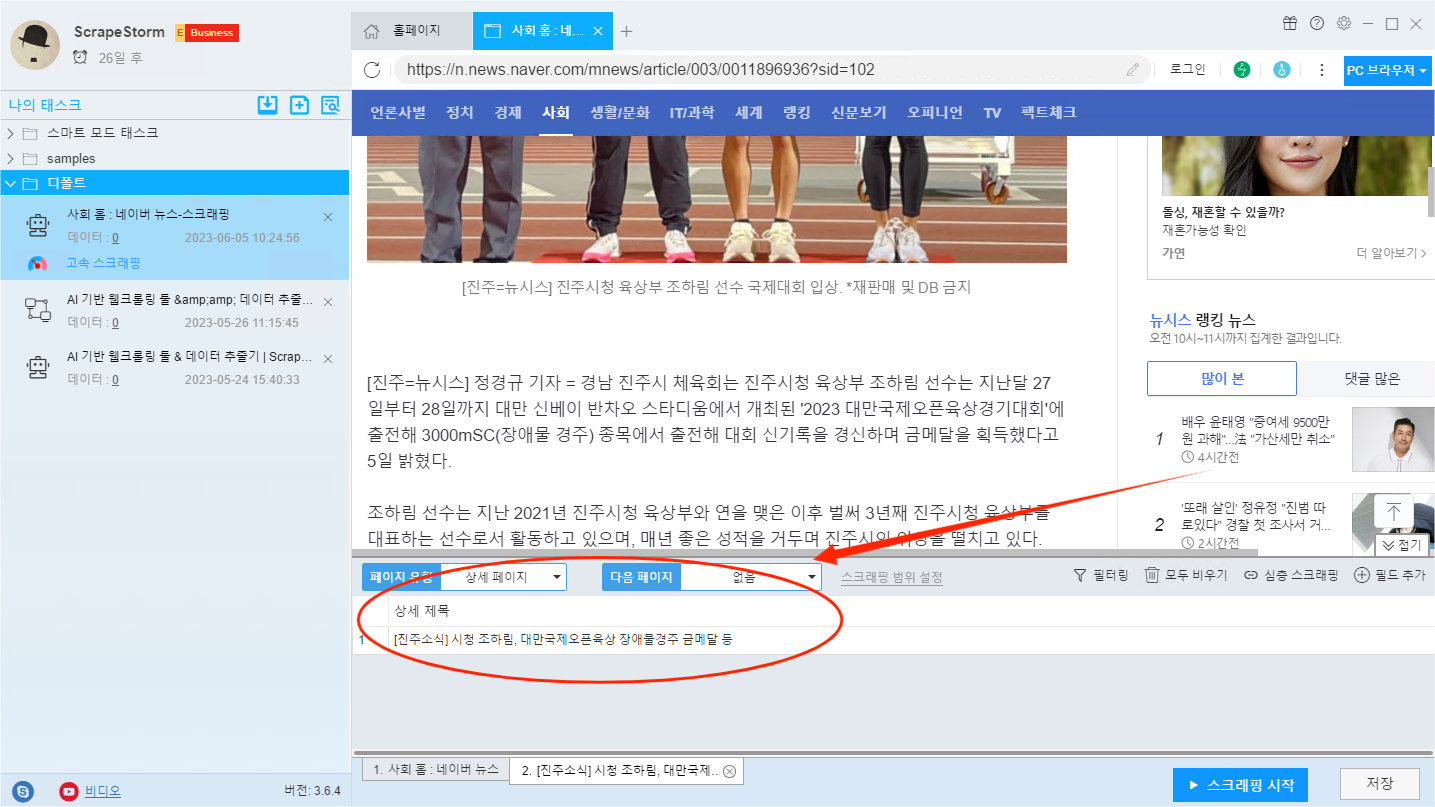

‘심층 스크래핑’버튼을 클릭하면 상세 페이지 인터페이스에 자동으로 들어가고 소프트웨어가 웹 페이지를 자동으로 인식하여 해당 필드를 자동으로 생성합니다. 아래 사진은 인식 완료된 상태입니다.

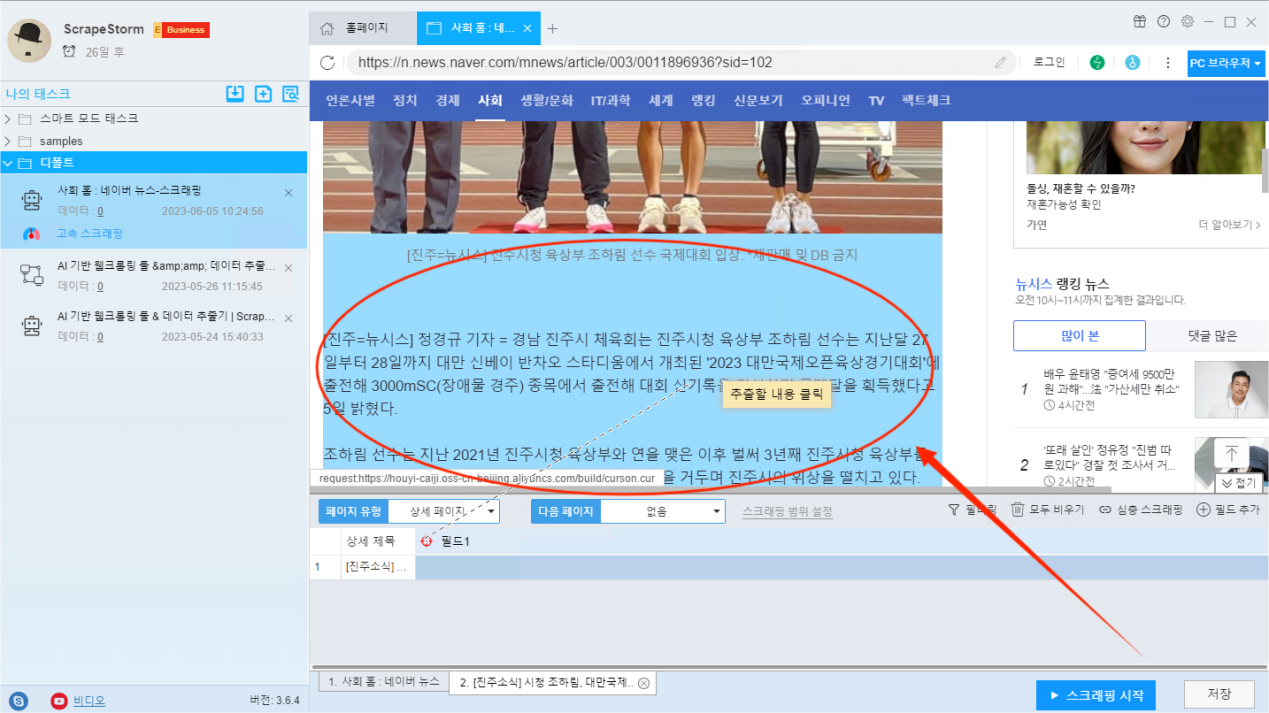

수집의 필요에 따라 필드를 수동으로 추가할 수도 있습니다. ‘필드 추가’ 버튼을 클릭하고 본문을 선택하면 해당 필드를 생성할 수 있습니다.

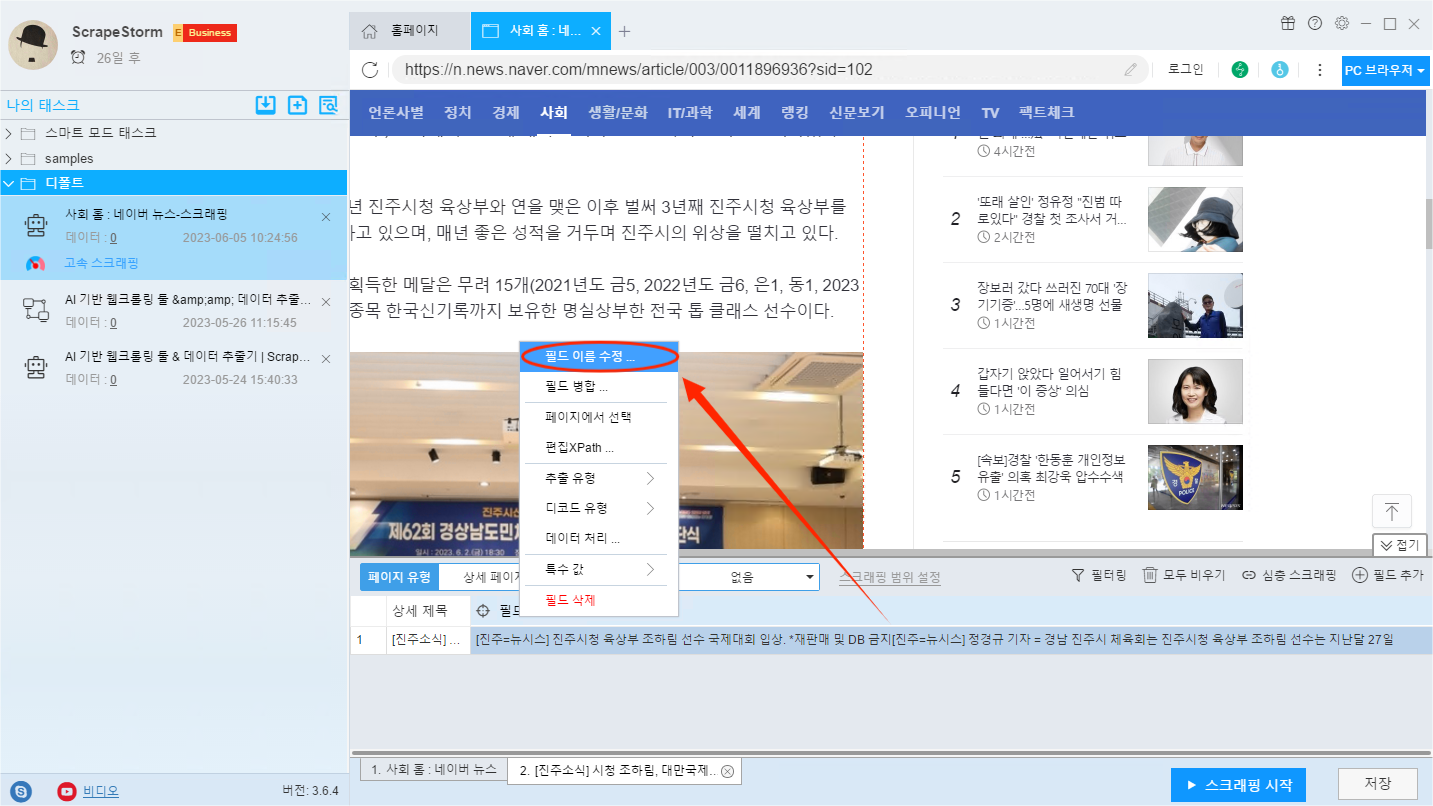

필드 이름 수정이 필요한 경우에는 먼저 필드 이름 수정이 필요한 필드를 선택합니다. 다음 오른쪽 버튼을 클릭하고‘필드 이름 수정… ‘를 선택합니다. 팝업창에서 기존 이름을 원하시는 이름으로 변경해주시면 됩니다.

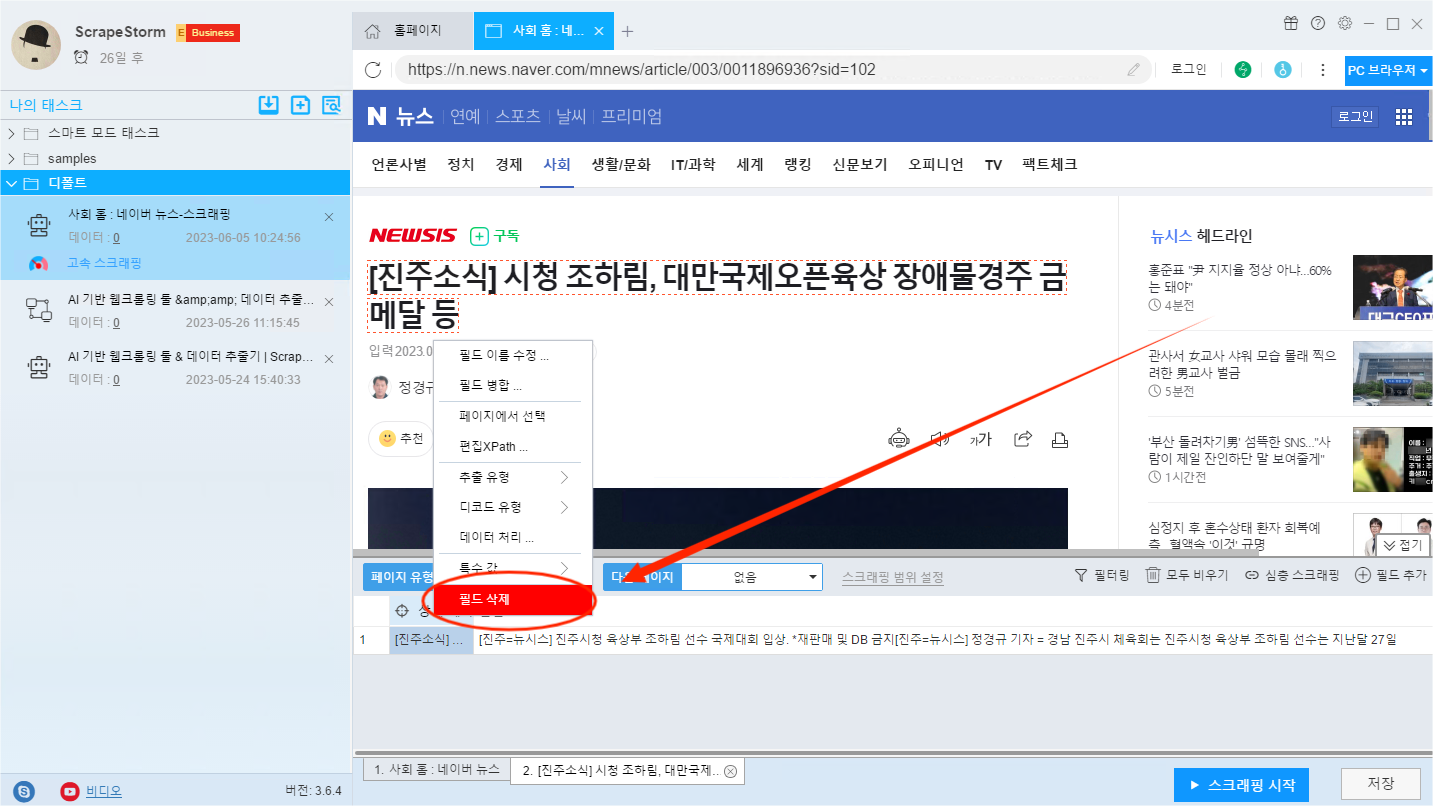

수집해야 할 필드를 남겨두고 수집 요구 사항이 없는 필드의 경우 필드를 선택하여 ‘삭제’ 를 마우스 오른쪽 단추로 클릭합니다.

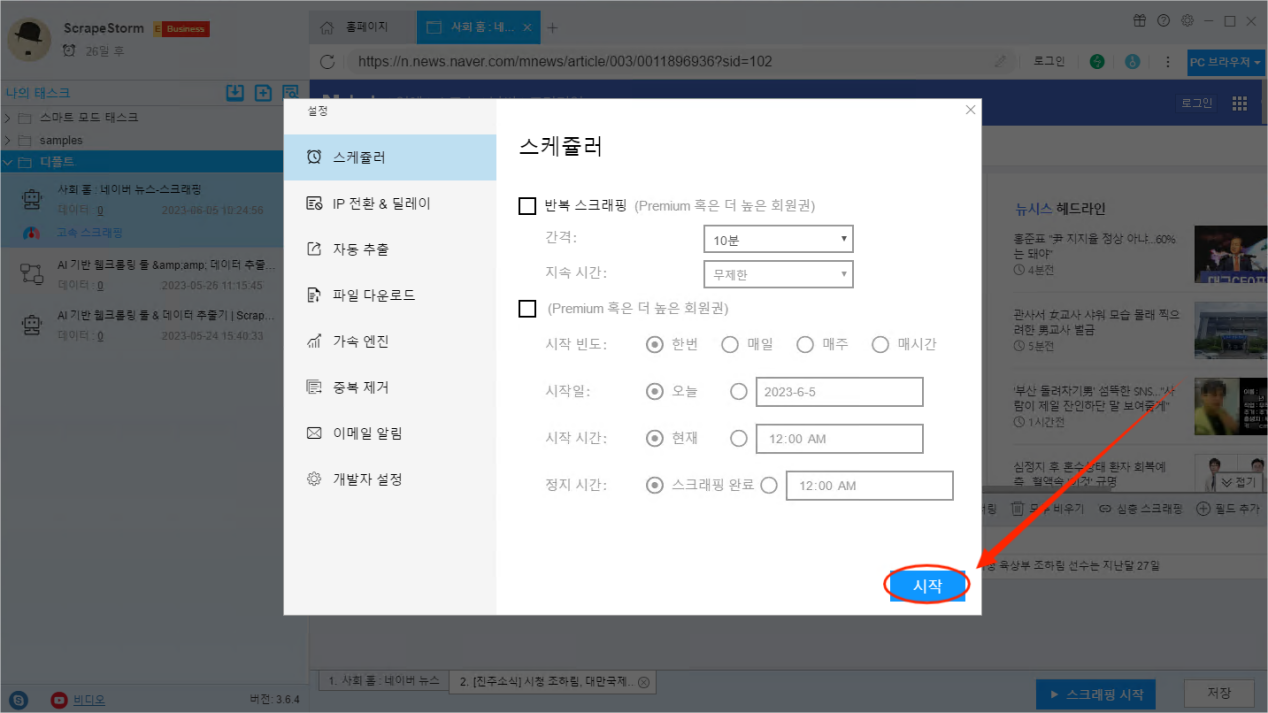

3. 태스크 시작하기

필드 설정을 완료한 후 ‘ 스크래핑 시작 ‘ 버튼을 클릭하면 구체적인 스크래핑 조건을 설정할 수 있습니다.스케쥴러, IP전환 딜레이, 자동 추출, 파일 다운로드 등 다양한 기능 설정을 포함합니다.설정이 완료되면 ‘시작‘ 버튼을 클릭하여스크래핑 태스크를 시작할 수 있습니다.

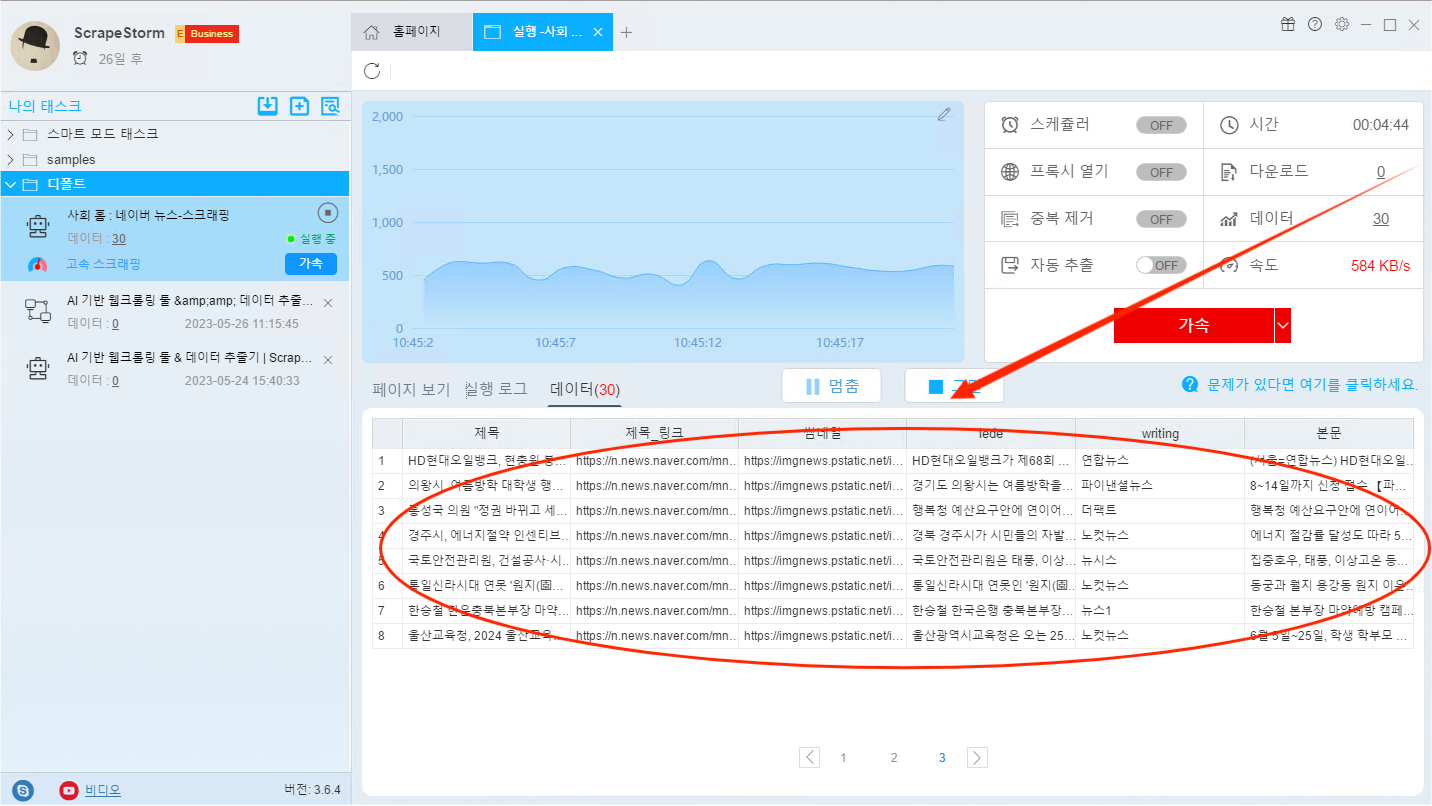

스크래핑 태스크가 실행되는 동안 수집된 데이터를 실시간으로 볼 수 있습니다.

4. 데이터 내보내기

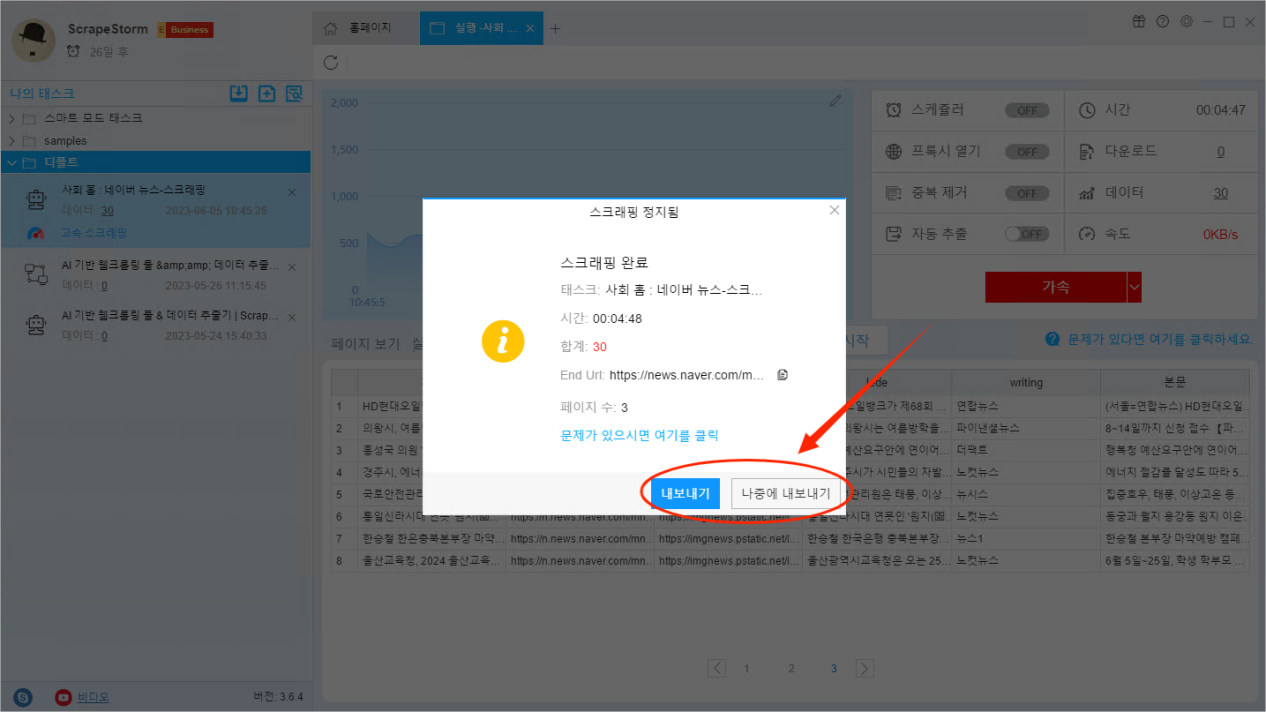

모든 데이터가 수집되면 소프트웨어가 자동으로 힌트를 보내므로 ‘내보내기‘ 거나 ‘나중에 내보내기‘ 버튼을 선택할 수 있습니다.

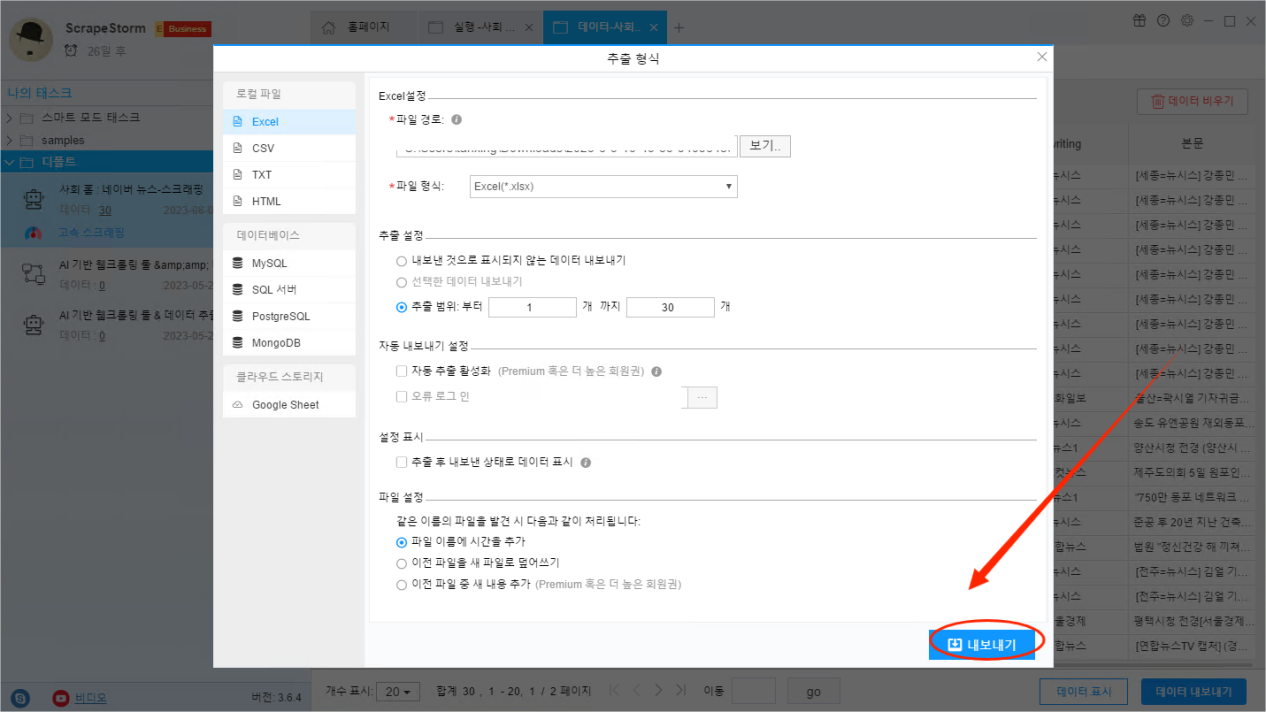

내보내기 유형에는 Excel, CSV, TXT, HTML 및 데이터베이스 MySQL, SQL Server, PostgreSQL, MongoDB, 그리고 Google Sheet가 포함되며 필요에 따라 적절한 데이터 내보내기 유형을 선택하시면 됩니다.

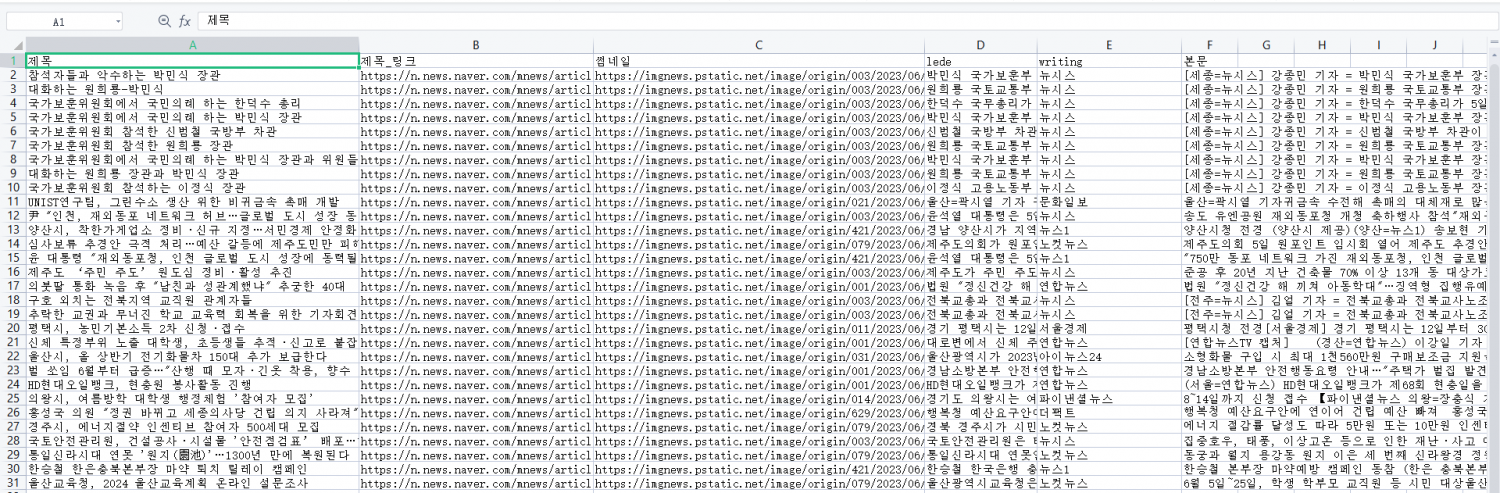

아래의 사진은 Excel로 내보낸 데이터 스크래핑 결과입니다.

ScrapeStorm을 이용한 데이터 수집 과정은 매우 간단하지 않나요? 대량 데이터 수집을 완료하는 데 4단계밖에 걸리지 않습니다. 당신의 작업에 많은 시간을 절약할 수 있습니다. 웹 데이터 대량 수집을 쉽게 실현하고 싶다면 어서 공식 웹 사이트에서 ScrapeStorm을 다운로드하고 튜토리얼을 따라 해보십시오~

면책 성명: 이 글은 우리 사용자에 의해 기여되었습니다. 침해가 발생한 경우 즉시 제거하도록 조언해 주세요.